AI语音实验箱,AI人工智能综合实验箱

2024-07-04 12:35DB-SD38 AI语音与机器视觉开发应用系统平台

AI语音与机器视觉开发应用系统平台是一款集成AI语音、机器视觉、深度学习、嵌入式Linux于一体的高端教学科研实验平台。

整个教学平台由实验箱高性能嵌入式主板够成,高性能嵌入式核心板采用高性能64位ARM处理器,标配4GB DDR3内存和16GB闪存,可运行ubuntu、android、linuxqt等多种操作系统,可满嵌入式linux和AI应用开发。

平台采用多核高性能 AI 处理器,预装 Ubuntu Linux 操作系统与 OpenCV 计算机视觉库,支持 TensorFlow Lite、NCNN、MNN、Paddle-Lite、MACE 等深度学习端侧推理框架。

提供多种应用外设与丰富的机器视觉、AI语音、深度学习实战应用案例,如语音前处理(声源定位、语音增强、语音降噪、回声消除、声音提取)、语音活体检查、语音唤醒、语音识别、语音合成、自然语言处理、声纹识别门锁、语音智能家居、手写字识别、人脸识别、目标检测、端侧推理框架、图像识别、人体分析 、文字识别、人脸门禁控制、车牌道闸控制、手势家居控制等,通过案例教学让学生掌握计算机视觉与深度学习的基本原理和典型应用开发。

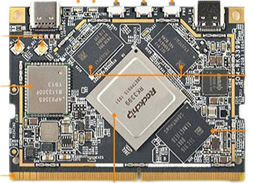

2.2.1. 嵌入式网关核心板

RK3399核心板是一款266-pin金手指形式高性能ARM计算机模块,它采用了瑞芯微64位六核(包含双核Cortex-A72 +四核Cortex-A53)Soc RK3399作为主处理器,标配4GB DDR3内存和16GB闪存,板载2×2 MIMO双天线Wi Fi模组,尺寸只有69.6×50mm,模块上带有独立的Typec供电接口,以及USB-C显示接口。

RK3399计算模块具有丰富的外设和扩展接口,可以扩展使用双MIPI宽动态摄像头,另外它还带有eDP显示接口,MIPI显示接口,1路USB3.0,2路USB2.0,以及12C,12S,SPI,PWM,GF10和串口等各种资源。RK3399可流畅运行Android 8.1,Ubuntu 18.04,Armbian,Buildroot等主流嵌入式操作系统,软件资源和生态非常丰富,尤其是Android 8.1具有NN SDK神经网络加速软件包,Qt-5.10集成了VPU硬件编解码,GPU图形加速,可使用QML快速开发流畅的动态式界面,因此RK3399核心板非常适合做高端人脸识别,机器视觉,VR虚拟现实,自动驾驶,深度计算分析等方面的人工智能产品快速原型及产品开发。

硬件参数:

| CPU |

SOC:RK3399 核心:64位双核Cortex-A72 +四核Cortex-A53 频率:Cortex-A72 (2.0 ghz), Cortex-A53 (1.5 ghz) |

| GPU | Mali-T864 GPU,支持OpenGL ES1.1/2.0/3.0/3.1、OpenVG1.1 OpenCL, DX11, AFBC |

| VPU | 4K VP9 and 4K 10bits H265/H264 60fps decoding, Dual VOP, etc |

| Memory | RAM: Dual-Channel 4GB DDR3 |

| Storage | eMMC: 16GB(regular), 32GB/64GB(optional), eMMC 5.1 |

| Power Management | RK808-D PMIC,配合独立直流/直流,启用dvf solfware省电,RTC唤醒,系统睡眠模式 |

| Connectivity |

以太网:本机千兆以太网 wi - fi: 802.11 a / b / g / n / ac 蓝牙:4.1双模式 天线:双天线接口 |

| Video Input | 1个或两个4-Lane MIPI-CSI,双重ISP, 13 mpix / s,同时支持双相机数据的输入 |

| Video Output |

HDMI: HDMI 2.0a, supports 4K@60Hz,HDCP 1.4/2.2 DP on Type-C: DisplayPort 1.2 Alt Mode on USB Type-C LCD Interface: one eDP 1.3(4-Lane,10.8Gbps), one or two 4-Lane MIPI-DSI |

| USB |

USB 2.0: 2独立的本地主机USB 2.0 USB 3.0: 1本地主机USB 3.0 USB c类型:支持USB3.0 c型和显示端口1.2 Alt模式USB c型 |

| PCIe | PCIe x4, compatible with PCIe 2.1, Dual operation mode |

| 调试 | 1 x调试UART, 3 v级,1500000个基点 |

| LED | 1x Power LED(Red) 1x GPIO LED(Green) |

| Key | Power Key x1 Reset Key x1 Recovery Key x1 |

| 工作温度 | -20℃ to 70℃ |

| 电源 | 直流12 v / 1(边缘连接器)或DV 5 v / 2.5 (c型) |

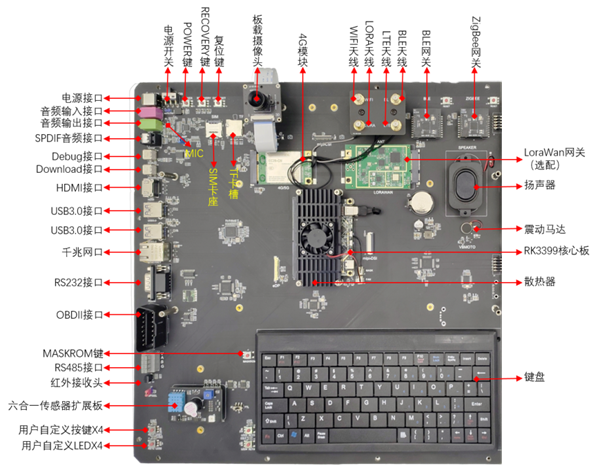

2.2.2. 网关底板其他外设

l 11.6寸高清触显一体屏:板载,eDP接口,电容式多点触摸,分辨率1920*1080

l 按键:板载重启、恢复、电源3个功能按键,4个用户自定义按键

l UART:1路RS232,1路RS485

l 以太网:100/1000M

l 音频:音频输出接口、MIC音频输入接口、板载4欧3W扬声器

l 无线网:WiFi (2.4G and 5G, 802.11 ac), Bluetooth 4.1

l 4G模组:板载,板载EC20模组

l LoRaWAN网关模块接口:板载mini-pcie接口,可接入SX1301八通道并行LoRaWAN网关模块。1个项目须至少配备1个LoRaWAN网关模块,以实现对实验室所有lora节点的接入管理。

l Zigbee网关模块:板载,直列双排20芯插针接口,非usb接口。

l BLE网关模块:板载,直列双排20芯插针接口,非usb接口。

l USB 3.0 HOST接口:板载2个

l Debug接口:板载1个

l Download接口:板载1个

l 键盘:板载7寸80键标准键盘

l 高清相机模组:CMOS传感器OV13850,MIPI信号输出,400万像素,最高支持2688x1520像素。

l 麦克风阵列:板载7颗数字高性能硅麦克风。

l 红外接收:板载红外接收模块1个

l 震动马达传感器:1个

l LED:板载4颗蓝色LED灯珠。

l 天线接口:板载wifi、BLE、lora、LET 共4个天线接口。

l 传感器扩展接口:板载,与无线传感器节点的传感器模块接口兼容,可完成linux系统下的传感器驱动开发实验。

l OBD接口:板载,标准16针OBD-II插座,与配套软件结合可完成基于CAN总线通信相关实验。

l

电源:DC 9-12V输入

l 其他接口:MIPI、GPIO、SPI、I2C、TF Card (sd/mmc 3.0)、SIM卡座、USB 2.0 HOST、USB Type-C (with DP out)、eDP 1.3、HDMI 2.0 for 4K 60Hz

2.3. 外设模块

2.3.1.

4G LTE模块l 网络:FDD-LTE/TDD-LTE/WCDMA/TD-SCDMA/GSM/EDGE;

l 制式:CMCC/CUCC(B1/B3/B8/B34/B38/B39/B40);

l 工作频带:HSPA1900/2100,GSM 900/1800;

l 高速USB 2.0接口、PCI-E接口;

l 支持短信、数据、电话本、PCM语音功能;

l 支持IPv4,IPv6协议;

l 支持LTE多频;

l 支持最大150M/50Mbps的理论上下行数据传输速率;

2.3.2. AI麦克风阵列

l 7路麦克风阵列,提供声源定位、语音增强、语音降噪、回声消除、声音拾取等功能。l 带硬件浮点运算的RISC-V 双核64位处理器,主频最高800MHz。

l 具备机器听觉能力和语音识别能力,内置语音处理单元(APU)。

l 具备卷积人工神经网络硬件加速器KPU,可高性能进行卷积人工神经网络运算。

l 麦克风阵列模块集成TFT彩屏屏,能够直观显示音频频谱图。

l 内置ARM STM32 USB音频驱动芯片,提供USB声卡驱动,开放源代码。

l 接口:双列直插封装/USB,需能够接入到eAIOT平台使用。

l 支持语音识别、语义理解、语音合成、人机对话等功能,可与硬件进行语音交互。

l 5米监测范围、基于linux系统。

2.3.3. AI摄像头

l 1/1.8" SONY Exmor CMOSl 有效像素200万像素,30帧@1920*1080

l C/CS镜头接口,最低照度0.001 Lux,120dB TWDR

l 支持协议:PROFILE S,GB/T28181,FTP/RTSP.UPNP等

l 支持双码流、手机监控、心跳机制,具3D降噪、去雾、数字宽动态、镜头校正、走廊监控等智能模式

l 提供基于eAIOT教学平台的人脸识别系统案例。

2.4. 物联网应用基础云平台

1、功能简介1)学生能够将物联网感知层设备(传感器、执行器等)接入物联网云服务平台,平台能够接收并存储传感器和执行器的实时数据,模块在线状态,并实时显示。

2)提供后台管理系统,能够设置账号类型和使用权限。支持多用户管理及权限控制,分为父用户和子用户,父用户可以创建多个子用户,并且可以为每个子用户分配增、删、改几种权限,子用户创建的资源相互隔离。

3)提供物联网规则编辑器,无需编写代码即可编辑复杂的自动化控制策略,实现移动互联网系统的自动化控制。

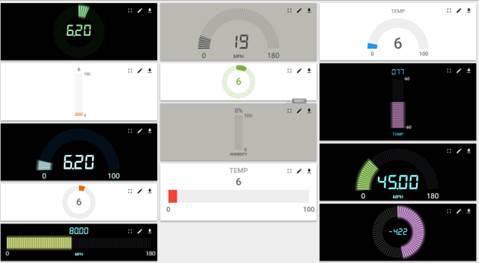

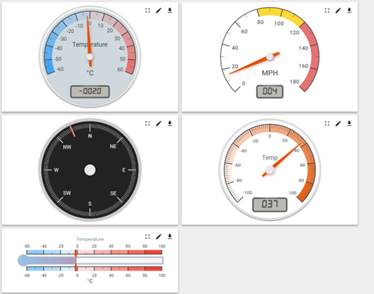

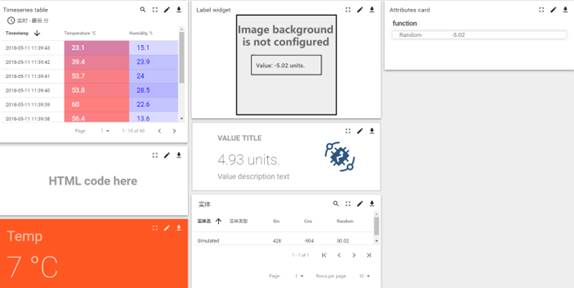

4)提供丰富的可视化控件库,通过拖拽、简便配置即可完成美观的UI设计。支持GIS地图、曲线图、柱状、饼图、图表、按钮、仪表图等控件。

5)物联网感知层设备也能够向执行器发送控制命令,系统能够实现模块的在线监测。

6)云平台支持物联网硬件多协议接入,通过ZigBee/BLE/wifi/lora/NBIOT无线技术取得传感器采集的数据,形成一个完整的无线传感器网络。

7)数据通过http/MQTT协议传输至物联网应用基础云平台软件,进行数据图形化展示。

8)实现基于云平台的智能家居实验,并包含配套完整的教学资源。

9)支持本地化部署和云端部署两种方式。

10)提供“物联网应用基础云平台”软件著作权登记证书及软件产品登记测试报告复印件并加盖公章,原件备查。

3. 部分实验案例

3.1.1. 嵌入式linuxQT综合实验

|

3.1.2. 手写字识别

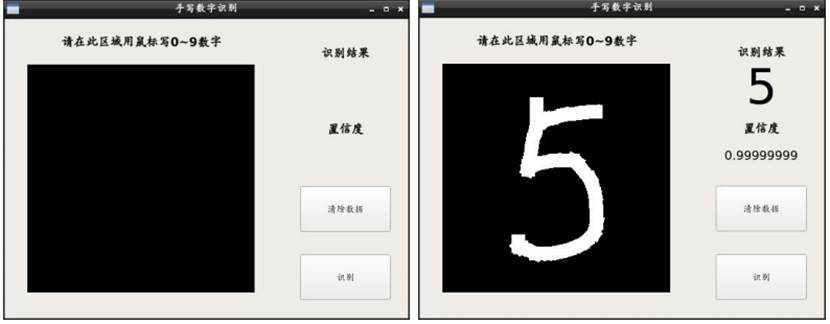

学习设计一个神经网络模型,然后用已经标注过的MNIST数据来训练这个模型,然后进行测试验证。

图:手写字识别案例

3.1.3. 人脸识别

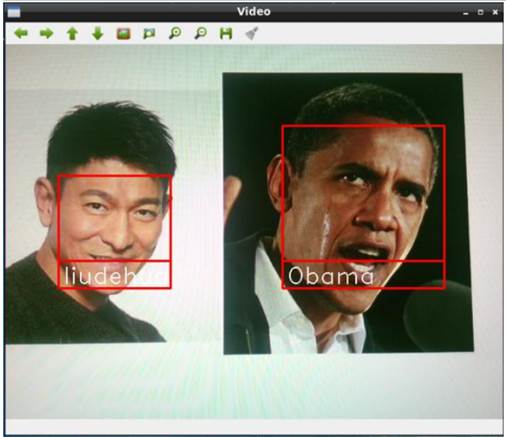

通过OpenCV自带的分类器、OpenCV的深度学习分类器是基于SSD(Single Shot Detector)框架的ResNet网络,实现在图片、视频中对人脸的检测,并用矩形框框出来。学校可用于身份识别、课堂/上下班考勤、会议签到、刷脸支付、门禁通行、安防监控相关场景。

图: 人脸识别案例

3.1.4. 目标检测

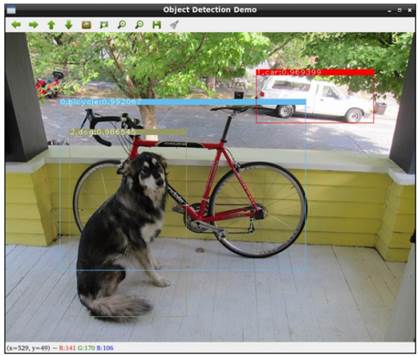

利用深度学习框架caffe,实现对常见物体的检测。

图:目标检测案例

3.1.5. 人体姿态识别

使用边缘侧推理框架Tengine检测图像中的所有人体并返回每个人体的矩形框位置,精准定位 21 个核心关键点,包含五官、四肢、脖颈等部位,更多关键点持续扩展中;支持多人检测、人体位置重叠、遮挡、背面、侧面、中低空俯拍、大动作等复杂场景。

图:人体姿态识别案例

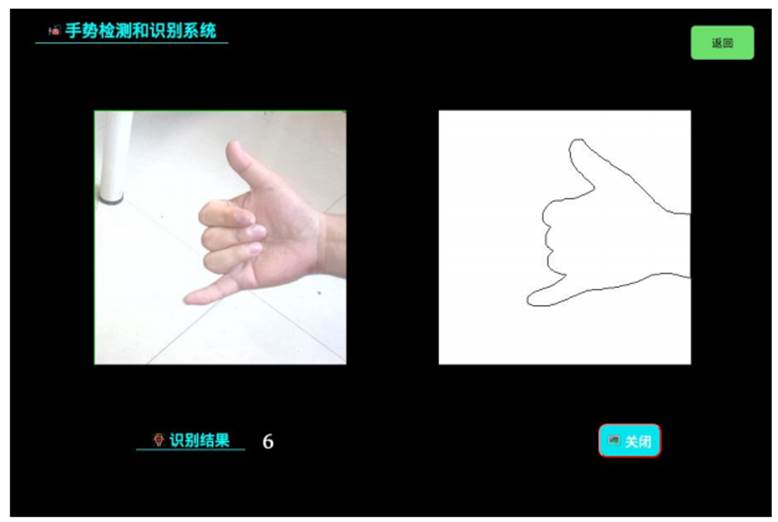

3.1.6. 手势识别

利用深度学习框架caffe,实现对简单手势的识别。

图:手势检测和识别系统案例

3.1.7. 车牌识别

使用opencv 的 HAAR Cascade 检测车牌大致位置,使用卷积神经网络回归车牌左右,然后使用卷积神经网络滑动窗切割字符、及识别字符。

图:交通门禁车牌检测和识别系统案例

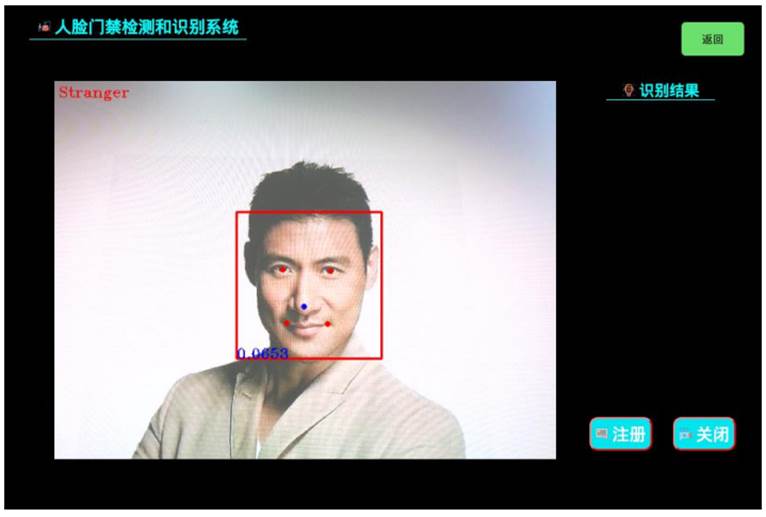

3.1.8. 人脸门禁

采用 mtcnn 进行人脸检测,采用MobileFaceNet 进行人脸识别,然后用活体检测算法进行检测。

图:人脸门禁检测和识别系统案例

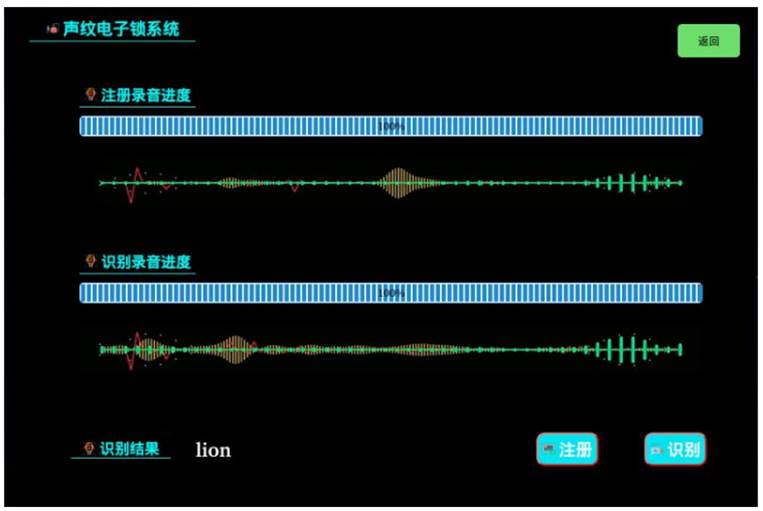

3.1.9. 声纹锁实验

通过语音增强、语音质量检测、语音增强、有效语音提取、声纹特征提取等步骤,完成声纹注册及声纹验证。

图:声纹电子锁系统案例

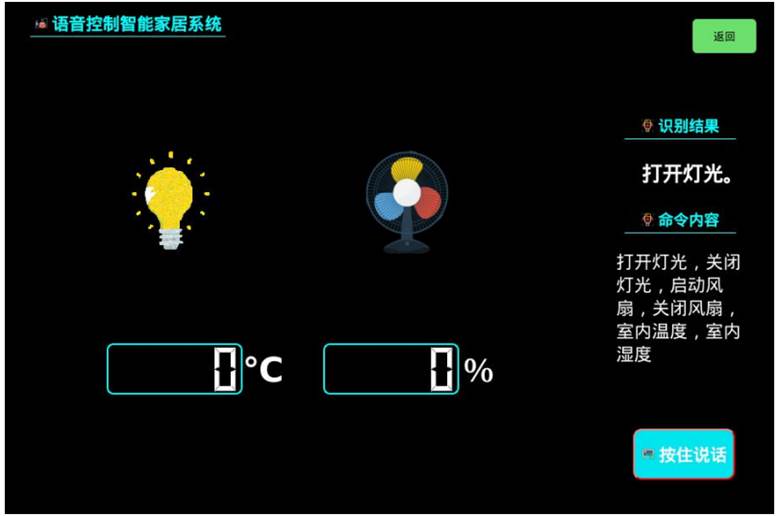

3.1.10. AI语音控制智能家居

本系统实现语音数据高速传输,基于百度语音识别 API 完成语音识别,并用无线方式控制电灯,电风扇,以及获取温度和湿度。

图:语音控制智能家居系统案例

3.1.11. 知识图谱和聊天机器人

知识图谱融合了两千五百多万的实体,拥有亿级别的实体属性关系,机器人采用了基于知识图谱的语义感知与理解,致力于最强认知大脑。自然语言处理工具包的功能有:中文分词、词性标注、命名实体识别、关键词提取、文本摘要、新词发现、情感分析等。

图:知识图谱和文本聊天机器人系统案例